总体概览

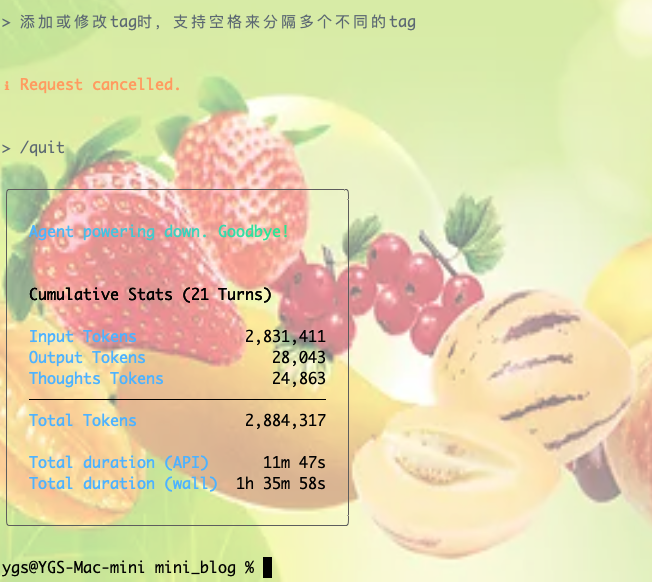

Agent powering down. Goodbye!: 这表示AI代理的会话已正常终止。

Cumulative Stats (21 Turns): 这句话是理解整个报告的关键。

Cumulative (累计的): 下方的所有数字都是整个会话期间(从开始到结束)的总和,而不是最后一次操作的数字。

21 Turns (21轮对话): 这意味着您和AI代理之间总共进行了21次一来一回的交互。

Token(令牌)相关字段

首先,理解什么是Token至关重要。在大型语言模型(LLM)中,文本不是按单词或字母处理的,而是按“Token”处理的。一个Token可以是一个完整的单词(如apple),也可以是一个词根、一个词缀或一个标点符号(如unbelievable可能被拆分为un、believe、able三个Token)。Token是模型处理和计费的基本单位。

Input Tokens (2,831,411)

含义: 这是在整个会话中,所有被发送给模型进行处理的Token总数。

它包括:

您输入的每一个问题和指令。

为了让模型记住上下文而发送的历史对话记录。

系统级的指令(例如,告诉模型其角色和行为准则的隐藏提示)。

模型使用的工具(如代码解释器、搜索引擎)返回的结果,这些结果也需要被模型“阅读”和理解。

解读: 这个数字非常大,说明在21轮对话中,模型处理了大量的上下文信息。这可能是因为您发送了很长的代码、文章,或者对话历史非常长。

Output Tokens (28,043)

含义: 这是模型在整个会话中,生成并最终展示给您的Token总数。

它包括:

模型生成的每一个回答。

代码块、解释、格式化的文本等。

解读: 这是模型“说出”或“写下”的总量。通常,输入Token数会远大于输出Token数,因为模型需要“阅读”大量上下文才能生成精确的回答。

Thoughts Tokens (24,863)

含义: 这是最能体现“Agent(代理)”特性的一个字段。它代表了模型的**“思考过程”或“内心独白”所消耗的Token总数**。

它是什么: 在执行复杂任务时,现代AI代理会使用一种叫做“思维链”(Chain of Thought)或类似的技术。它会先生成一个内部的、不对用户显示的思考步骤(例如:“用户想让我修改代码。第一步,我需要理解代码的逻辑。第二步,定位到需要修改的函数。第三步,编写新代码并进行测试。”)。这个思考过程本身也是由模型生成的,所以会消耗Token。

解读: 这个数字表明,该AI代理在回答您的问题时,进行了大量的内部规划和推理,而不仅仅是直接给出答案。

Total Tokens (2,884,317)

含义: 所有消耗的Token总和。

计算公式: Total Tokens ≈ Input Tokens + Output Tokens + Thoughts Tokens。

解读: 这个数字通常是API服务提供商用来计算费用的最终依据。

Duration(时长)相关字段

Total duration (API) (11m 47s)

含义: 这代表了在整个会话中,AI模型的计算核心真正在服务器上运行和处理请求所花费的总时间。可以理解为模型的“纯思考时间”或“CPU/GPU时间”。

解读: 尽管整个会话持续了一个半小时,但模型实际高速运转的时间只有不到12分钟。

Total duration (wall) (1h 35m 58s)

含义: 这是指从会话开始到结束,现实世界中流逝的总时间(就像墙上的挂钟走过的时间,因此叫“Wall Time”)。

它包括:

Total duration (API)(模型的计算时间)。

您思考和输入下一个问题所花费的时间。

网络数据传输的延迟时间。

AI代理等待您响应的空闲时间。

解读: 这个时间和API时长的巨大差异(1.5小时 vs 12分钟)清晰地表明,在整个交互过程中,绝大部分时间是花在了用户侧(您)或者网络传输上,而不是AI模型的计算上。

总结与比喻

您可以把这次交互想象成您雇佣了一位超级顾问(AI代理)来完成一项持续一个半小时的任务。

Wall Time (1h 35m 58s): 您和顾问在一起工作的总时长。

API Time (11m 47s): 顾问真正开动脑筋、奋笔疾书的净工作时长。

Input Tokens: 您提供给顾问的所有背景资料、书籍和要求。

Output Tokens: 顾问最终写给您的报告和总结。

Thoughts Tokens: 顾问在草稿纸上打的草稿、列的提纲和做的头脑风暴。

Total Tokens: 顾问完成这项任务所阅读和书写的总字数,是您支付其薪酬的依据。